NC AI의 엔비디아 B200 PoC | 독자 AI 파운데이션 기업의 컴퓨팅 인프라 검증

Elice

2025. 11. 26.

생성형 AI 확산과 함께 대규모 모델 연구 환경은 이전보다 훨씬 복잡해졌습니다. 이제는 단순히 더 강력한 GPU를 도입하는 것뿐만 아니라 네트워크 구조, 저장 방식, 분산 학습 전략, 데이터 흐름까지 함께 설계해야 안정적인 연구가 가능합니다.

멀티모달 AI 모델 ‘바르코(Varco)’를 개발한 NC AI는 과기정통부의 ‘독자 AI 파운데이션 모델(국가대표 AI)’ 프로젝트 최종 5개 팀 중 하나입니다. 본 사업은 한국형 LLM·멀티모달 모델을 자체 역량으로 개발하기 위한 국가 전략 과제로 대규모 모델 연구 및 실사용 확산을 추진하고 있습니다.

이러한 맥락에서 NC AI는 차세대 GPU인 NVIDIA B200의 실제 연구 워크로드 성능을 확인하고 대규모 모델 학습 인프라로서 엘리스클라우드의 안정성과 확장 가능성을 평가하기 위해 PoC를 진행하였습니다. 엘리스클라우드는 초기 환경 구성부터 학습 실행, 안정성 검증까지 전 과정을 함께 수행하며 B200 기반 연구 환경의 실사용 가능성을 점검했습니다.

이번 실험은 단순히 GPU 성능을 비교하는 것이 아니라 기존 H100 환경에서 B200으로 전환했을 때 기존 학습 파이프라인을 얼마나 변경해야 하는지, 분산 학습·데이터 로딩·체크포인트 저장이 안정적으로 동작하는지, 그리고 초기 운영 단계에서 필요한 설정 및 가이드는 무엇인지 확인하는 데 목적이 있었습니다. 즉 빠른 세팅을 통해 B200으로 변경시 사양에 어떤 변화가 있는지 검증하는 과정이었습니다.

실제 연구 환경 수준의 B200 클러스터 구성

PoC 환경은 주어진 시간을 감안하여 실제 형태보다 조금 작지만 실제 모델 실험을 수행할 수 있는 형태로 구성했습니다. 이를 통해 새로운 GPU 아키텍처 도입 시 필수적으로 확인해야 하는 요소들(분산 학습 운영과 데이터 처리 흐름, 스토리지와 네트워크의 상관성 등)을 검토했습니다.

구성 환경은 다음과 같았습니다.

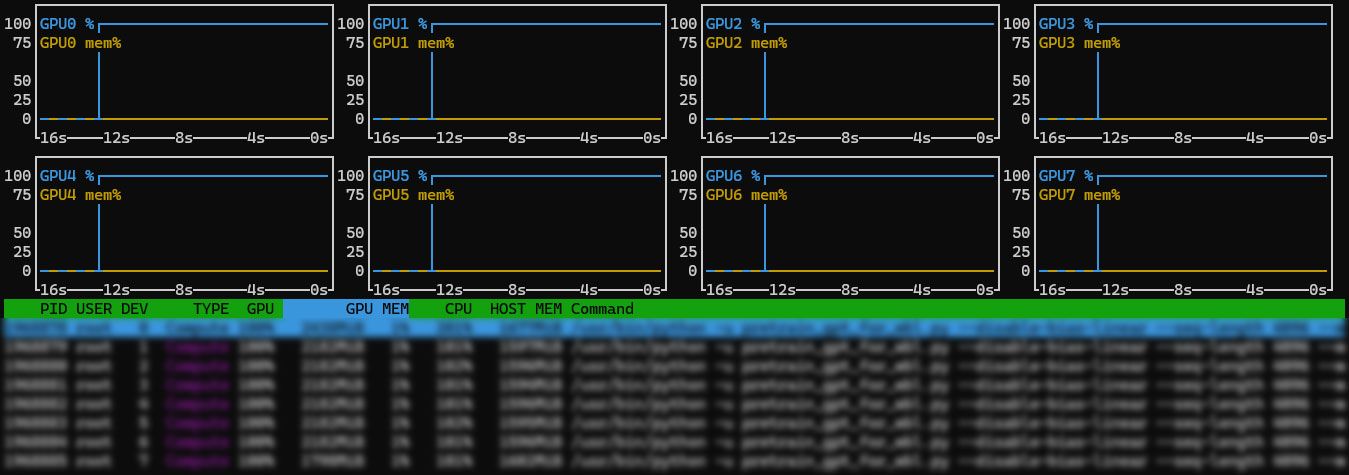

NVIDIA B200 GPU 8개 × 2노드

InfiniBand 기반 고대역폭 네트워크

NVMe 로컬 스토리지 약 30TB

Docker 기반 실행 환경

PyTorch · Megatron-LM · NCCL 기반 분산 학습

내부 및 외부 오브젝트 스토리지 연동

연구 환경 차이로 인한 영향을 줄이기 위해 기존 NC AI의 학습 방식과 최대한 비슷하게 구성했습니다.

연구 흐름을 그대로 반영한 검증 방식

PoC는 실제 연구자가 GPU 환경을 사용할 때 거치는 절차를 그대로 따르는 방식으로 진행했습니다.

드라이버 및 라이브러리 설치

컨테이너 환경 설정 및 패키지 검증

NVMe 스토리지 연결 및 처리 성능 확인

InfiniBand 대역폭 확인 및 통신 설정 조정

내·외부 S3 데이터 로딩 및 처리 성능 점검

분산 학습 실행 및 로그 기반 안정성 확인

FP8 학습 및 최신 Attention 방식 테스트

체크포인트 저장 및 재시작 검증

이 과정에서 중요한 기준은 반복 실험 가능성, 동일한 실행이 재현될 수 있어야 한다는 것이었습니다. 따라서 초기 세팅부터 학습 로그와 재실행 검증까지 모두 기록하며 진행했습니다.

설정·실행·기록을 함께하며 재현성을 높이는 공동 엔지니어링 방식

▲ POC 기록 예시

새로운 아키텍처 기반 환경은 문서만으로 파악하기 어려운 영역이 존재합니다. 이에 이번 PoC는 세팅–실행–점검 단계마다 정보를 공유하고, 실험 중 발견 사항을 즉시 반영하는 방식으로 진행했습니다.

이 과정에서 대규모 데이터 업로드 중 발생한 타임아웃을 조정하고, 컨테이너 환경의 초기 설정 가이드를 수립했으며, InfiniBand 네트워크 연결 시 필요한 파라미터를 조정하는 등의 작업이 이루어졌습니다.

덕분에 분산 학습과 스토리지 처리 단계에서 초기 튜닝 포인트가 도출되었고, 이를 바탕으로 재실행 시 안정적인 학습 환경을 확보했습니다. 엘리스는 이 과정을 기반으로 운영 가이드를 정리하고, 향후 대규모 학습 환경에서도 동일하게 적용할 수 있도록 준비했습니다.

차세대 GPU 전환의 가능성을 확인한 실험

이번 PoC를 통해 B200 환경이 실제 연구 워크로드에서 안정적으로 작동할 수 있음을 확인했습니다. 초기에는 H100 대비 즉각적인 성능 향상이 나타나지 않았지만, 이는 신규 아키텍처 도입 시 일반적으로 거치는 최적화 구간으로 판단했습니다.

중요한 점은 절대적인 수치보다 안정적 전환 기반 확보에 있습니다. 환경 초기 설정이 정리되었고, 재현 가능한 절차가 마련되었으며, 실제 운영 상황에서 필요한 체크 포인트를 확보했습니다. 이를 통해 이후 튜닝 방향이 명확해졌고, 반복 실험 및 확장 적용이 가능한 기반도 마련했습니다.

즉 이번 PoC는 단순한 성능 실험이 아니라 NC AI가 차세대 GPU 아키텍처를 직접 체험하고 연구 환경에 적합한 운영 기준을 탐색할 수 있었던 기회였습니다.

비록 즉각적인 효율 향상은 확인되지 않았지만 새로운 GPU 구조에 대한 이해와 초기 셋업 경험을 통해 향후 전환 과정에서 시행착오를 줄일 수 있는 중요한 인사이트를 얻었습니다. NC AI는 이번 실험을 계기로 B200의 활용 가능성을 높게 평가하고 있으며, 향후 연구 환경 도입까지 검토하고 있습니다.

엘리스클라우드와 함께하는 AI 인프라 전환

이번 PoC를 통해 NC AI는 B200 기반 환경이 실제 연구 워크로드에서 안정적으로 작동할 수 있는 조건과 운영 기준을 확인했습니다. 초기 튜닝이 필요한 영역도 파악했으며, 이를 기반으로 최적화 방향을 설정했습니다.

차세대 GPU 도입은 단순 하드웨어 성능 검증을 넘어 연구 환경과 운영 체계를 함께 정비해야 하는 과제입니다. 엘리스는 아시아 최초 수랭식 NVIDIA B200 데이터센터 인프라와 실제 고객사 PoC 경험을 바탕으로 연구 조직이 안정적으로 새 환경을 도입하고 확장할 수 있도록 지원합니다.