NVIDIA B200: 초거대 AI 시대를 위한 새로운 표준 GPU

Elice

2025. 7. 14.

1. 커도 너무 큰 초거대 언어모델(LLM), 인프라 병목은 어떻게 해결할까?

GPT-4, LLaMA 3, Claude 3 Opus 등 수백억~수조 개 파라미터의 초거대 모델이 등장하면서, 기존 GPU 서버 인프라로는 처리에 한계가 드러나고 있습니다.

메모리 부족으로 인한 모델 쪼개기부터 GPU 간 통신 병목, 실시간 추론 속도 미달, 전력 소비 및 운영비용 증가 등 다양한 문제가 발생하고 있죠.

이러한 문제들은 단순히 GPU 개수를 늘리는 방식으로는 해결할 수 없습니다. AI 인프라 자체를 다시 설계해야 할 시점이 온 것이죠.

이 과제를 정면으로 해결한 것이 바로 NVIDIA B200입니다.

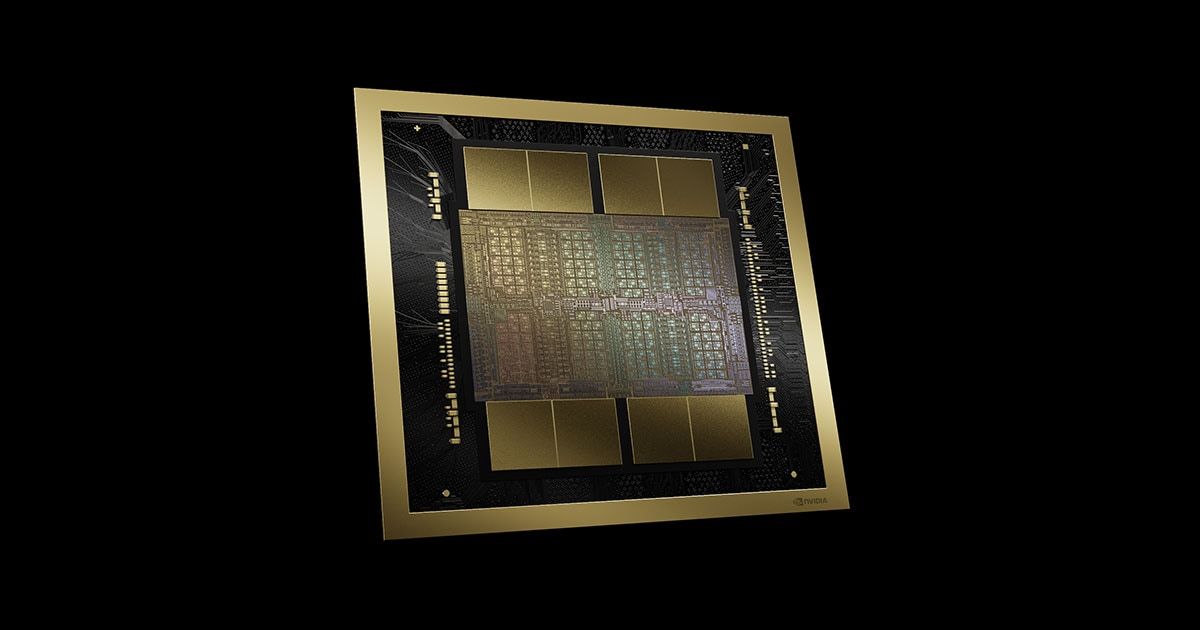

2. NVIDIA B200: Blackwell 아키텍처 기반의 차세대 GPU

NVIDIA B200은 새로운 AI 전용 아키텍처 Blackwell 기반의 고성능 GPU입니다.

이전 세대인 H100 대비, 메모리는 더 크고, 통신은 더 빠르고, 성능은 더 효율적입니다.

B200 주요 사양 한눈에 보기

| 항목 | 사양 |

|---|---|

| 아키텍처 | Blackwell |

| GPU 메모리 | 180GB HBM3E |

| FP8 학습 성능 | 72 PFLOPS (8× GPU 기준) |

| FP4 추론 성능 | 144 PFLOPS (8× GPU 기준) |

| NVLink 대역폭 | 1.8TB/s |

| 폼팩터 | SXM6 |

| 활용 분야 | 초거대 LLM 학습, 초저지연 추론, AI 시뮬레이션 등 |

3. H100 vs B200 주요 성능 비교

| 항목 | H100 | B200 |

|---|---|---|

| GPU 메모리 | 80GB | 180GB |

| NVLink 대역폭 | 900 GB/s | 1.8 TB/s |

| FP8 학습 성능(단일 GPU) | 최대 4 PFLOPS | 최대 18 PFLOPS |

| AI 모델 처리 효율 | 메모리 분산 필요 | 단일 환경 처리 가능 |

4. 1,000 TPS 이상의 실시간 추론 – 검증된 성능

NVIDIA의 공식 벤치마크에 따르면 B200 GPU 기반 환경은 Meta의 LLaMA 4 Maverick 모델을 통해 1,038 토큰/초/사용자 처리 성능을 기록했습니다.

*출처: NVIDIA 공식 블로그 보기

이 수치는 단순히 빠르다는 수준이 아니라, 이제 단일 인스턴스에서도 GPT‑4급 모델의 실시간 추론이 가능하다는 의미를 담고 있습니다.

- 챗봇의 지연 현상 최소화

- 대화형 AI·검색형 LLM 실시간 응답 가능

- 대규모 동시 사용자 처리도 가능

5. 이런 기업·기관이라면 B200으로 전환하세요!

B200은 단순히 ‘고사양 장비’가 아닙니다. 지금까지의 인프라로는 한계에 부딪힌 조직에게 실질적인 해답이 되는 새로운 세대의 서버입니다.

| 유형 | 필요 사유 |

|---|---|

| 초거대 모델 개발 조직 | GPT-4급 모델도 학습/추론 가능, 장비 통합 |

| SaaS·생성형 AI 기업 | 고속 추론 + 운영비용 절감 |

| AI 연구소/대학/국책기관 | 대규모 모델 실험, 튜닝, 추론 |

| 바이오/제조/미디어 기업 | 시뮬레이션 및 생성형 AI 실시간 운영 |

| AI /클라우드 플랫폼 사업자 | 대규모 LLM 서비스 백엔드용 서버 구축 |

6. 출시 일정과 국내 도입 현황

- 2024년 3월: NVIDIA GTC에서 B200 공식 공개

- 2025년 2월: 국내 AdTech 기업 PYLER 최초 도입

→ 실시간 영상 분석, 광고 타게팅 인프라에 적용

→ 기존 대비 연산 성능 30배 향상

현재 국내 도입은 초기 단계지만 초거대 모델을 직접 운영하려는 기업과 연구기관을 중심으로 빠르게 확산되고 있습니다.

7. B200, 우리에게도 필요할까? 엘리스가 제안하는 2가지 활용 방식

엘리스는 NVIDIA B200을 보다 쉽게 사용할 수 있도록 고객 맞춤형 도입 방식을 제공하고 있습니다.

① 클라우드 기반 B200 인프라

- 초기 구축 없이 바로 사용 가능

- NVIDIA AI Enterprise 포함, 전체 AI 워크플로우 지원

- 학습·튜닝·추론에 맞게 구성 가능

- 자원 사용량에 따라 유연하게 확장 가능

→ 복잡한 물리적 인프라 없이도 B200의 풀스펙을 온디맨드로 활용할 수 있는 구조입니다.

추천 대상:

- 비용 대비 성능이 중요한 스타트업, 연구팀

- 단기 프로젝트나 모델 파인튜닝용 GPU가 필요한 조직

- 설치형 인프라가 부담되는 기업

② B200을 품은 AI 데이터센터(PMDC)

엘리스는 B200을 탑재한 모듈형 AI 데이터센터(PMDC) 를 제공합니다.

AI PMDC는 빠른 구축 속도와 뛰어난 확장성을 갖춘 구조로, 비용과 시간이 많이 드는 전통적인 데이터센터 구축을 대체할 수 있는 현실적인 대안으로 주목받고 있습니다.

| 특징 | 설명 |

|---|---|

| 빠른 구축 | 3~4개월 이내 설치 완료 |

| 저렴한 비용 | 일반 데이터센터 대비 TCO 절반 수준으로 대폭 절감 |

| 자유로운 확장 | 필요 시 블록 단위로 증설 가능, GPU 교체도 유연 |

추천 대상:

- 자체 인프라 운영이 필요한 기관·대기업

- 보안상 클라우드 사용이 어려운 공공기관

- 장기적 AI 인프라 전략이 필요한 조직

✅ B200의 성능을 가장 빠르게 경험하는 방법?

엘리스가 준비한 B200 전용 프로모션을 확인해보세요.

- #엘리스클라우드

- #B200