한국어 특화 LLM, 엘리스 Korean Qwen2.5 모델 리뷰 (32B/72B)

Elice

2025. 4. 2.

한국어에 특화된 LLM, 엘리스 Korean Qwen2.5 모델 리뷰 (32B/72B)

혹시 GPT나 클로드 등을 사용하다 한글로 대화 중 영어로 답변을 받아 당황해본적이 있으신가요?

이처럼 오픈소스 LLM의 성능이 아무리 좋아도 한국어에 대한 이해가 부족하면 실서비스에 바로 활용하긴 어렵습니다.

그래서 이번에는 엘리스가 공개한 한국어 특화 LLM, Korean Qwen2.5 Instruct 모델의 성능을 리뷰해보고자 합니다.

왜 한국어 LLM이 따로 필요할까요?

많은 글로벌 AI 모델들이 다국어(Multilingual)을 표방하지만, 실제 사용에 있어서는 아쉬운 상황이 종종 발생하곤 합니다.

예를 들어 영어 중심으로 학습된 GPT나 Mistral 기반 모델들은 한국어로 질문을 해도 영어로 답변을 줄 때가 있죠.

이런 언어 전환 오류(language switching error)는 실제 챗봇 서비스나 검색 기반 QA 시스템에 있어서는 큰 장애가 될 수 있습니다.

엘리스의 Korean Qwen2.5는 이 문제를 정면 돌파하여 실제로 약 10%까지 발생하던 언어 스위칭 오류를 0% 수준으로 감소시켰습니다.

Qwen2.5는 어떤 모델인가요?

Qwen2.5는 알리바바에서 오픈소스로 공개한 고성능 LLM 모델입니다. 엘리스는 이 모델을 한국어 특화 방향으로 커스터마이징하여 32B, 72B 두 가지 버전의 Instruct 모델을 최적화했습니다.

- Qwen2.5-32B-Instruct → 단일 고성능 GPU에서도 실행 가능

- Qwen2.5-72B-Instruct → 멀티 GPU 환경에서 초대형 처리 가능

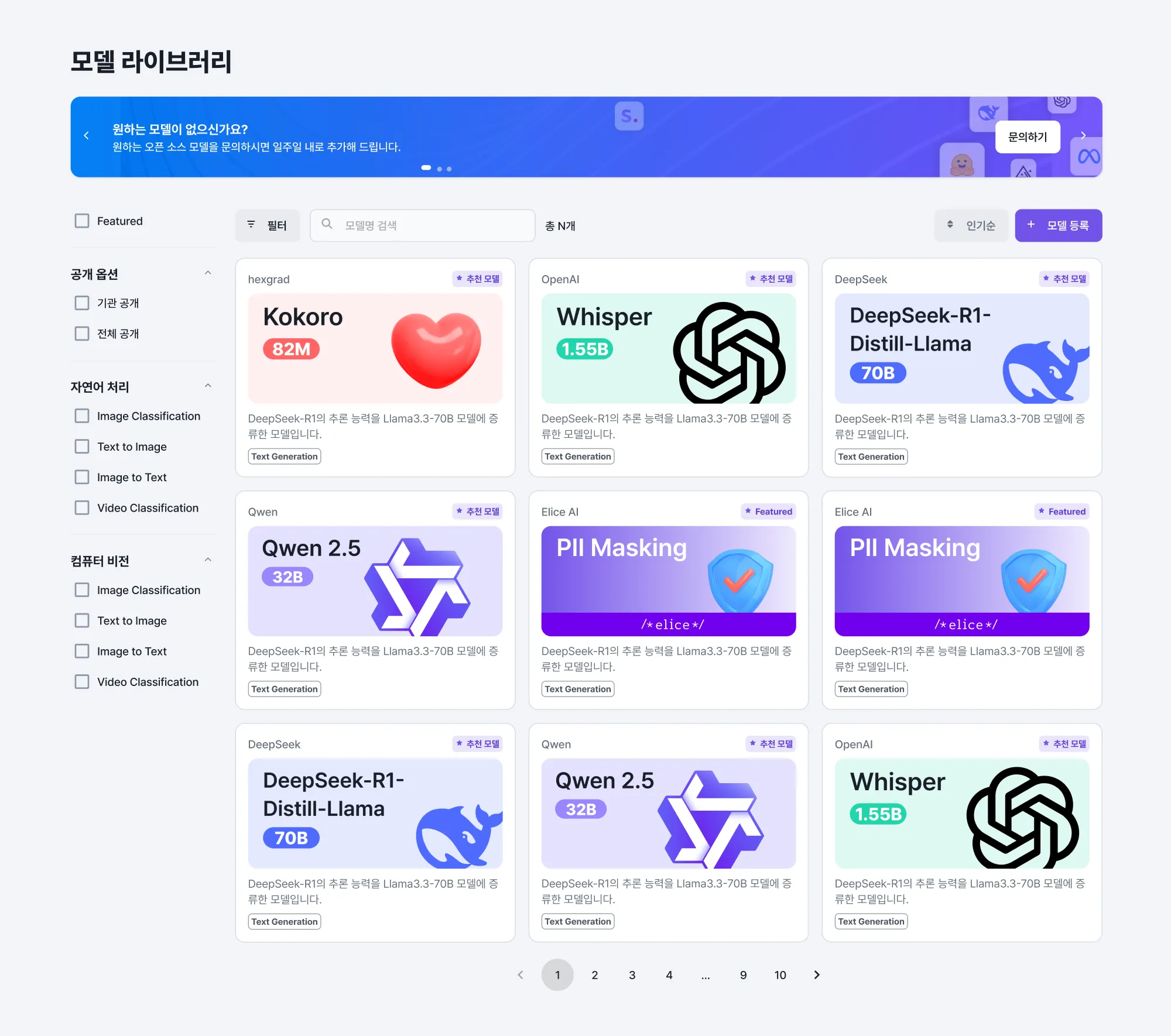

(이 두 모델은 현재 엘리스클라우드 모델 라이브러리에서 바로 사용 가능합니다.)

모델 최적화 방법

최적화를 위한 데이터는 아래와 같습니다.

- 공공 데이터셋

- 정부 공식 웹사이트에서 크롤링한 높은 신뢰도의 문서

- 정제된 오픈소스 한국어 코퍼스

그리고 파인튜닝은 최신 정렬 기법을 활용했습니다.

- SFT(Supervised Fine-Tuning)

- RLHF(Reinforcement Learning from Human Feedback)

- DPO(Direct Preference Optimization)

이러한 다단계 정렬 과정 덕분에 모델은 실제 맥락에 맞는 유용하고 안전한 출력을 만들어낼 수 있었습니다.

8개의 H100 GPU로 단 2일 만에 학습

엘리스는 이런 고성능 모델을 고작 8개의 H100 GPU로 단 이틀 만에 학습을 마칠 수 있었습니다.

단순히 하드웨어의 힘만이 아니라, 효율적인 엔지니어링과 탄탄한 AI 개발 파이프라인이 있었기에 가능했던 결과죠. 가격 역시 합리적이라 (시간당 33,600원 수준) 진행하는 프로젝트 규모에 맞춰 유연한 구성이 가능합니다.

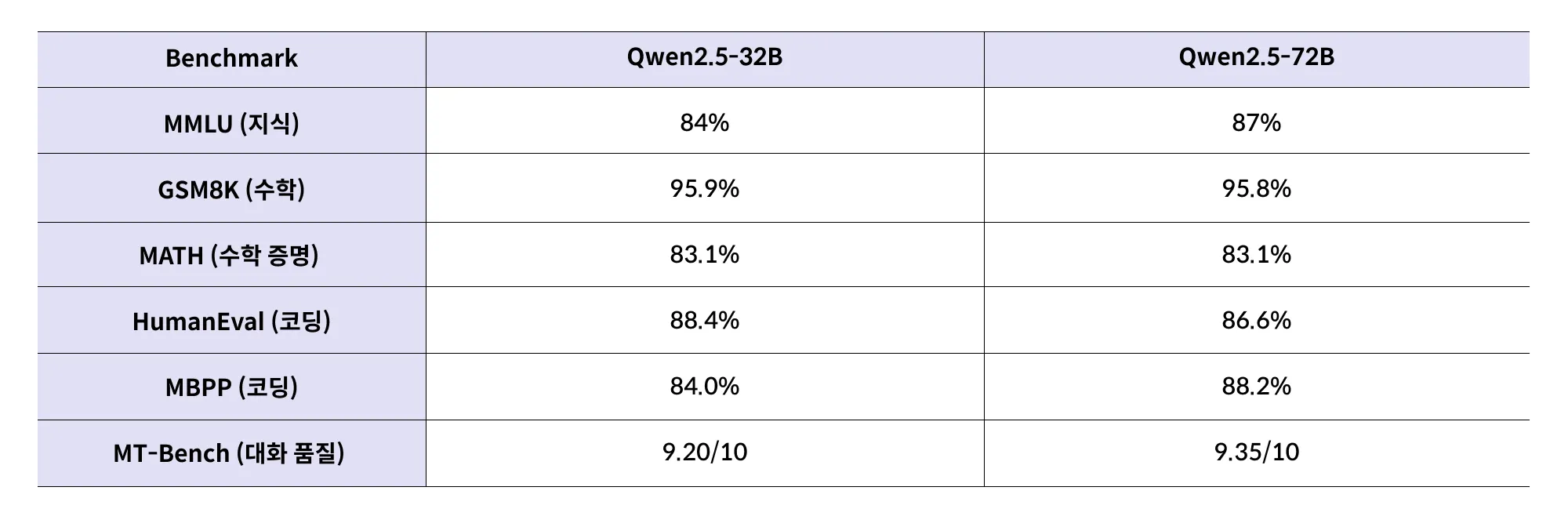

성능은 어느 정도일까요? (벤치마크 포함)

지금부터는 엘리스 Korean Qwen2.5 모델의 주요 성능 수치를 벤치마크하여 실제 성능을 한 번 살펴보겠습니다.

모든 항목에서 상당히 높은 점수를 기록하고 있으며, 특히 코딩과 수학 분야에서 성능이 높게 나온다는 것을 알 수 있습니다.

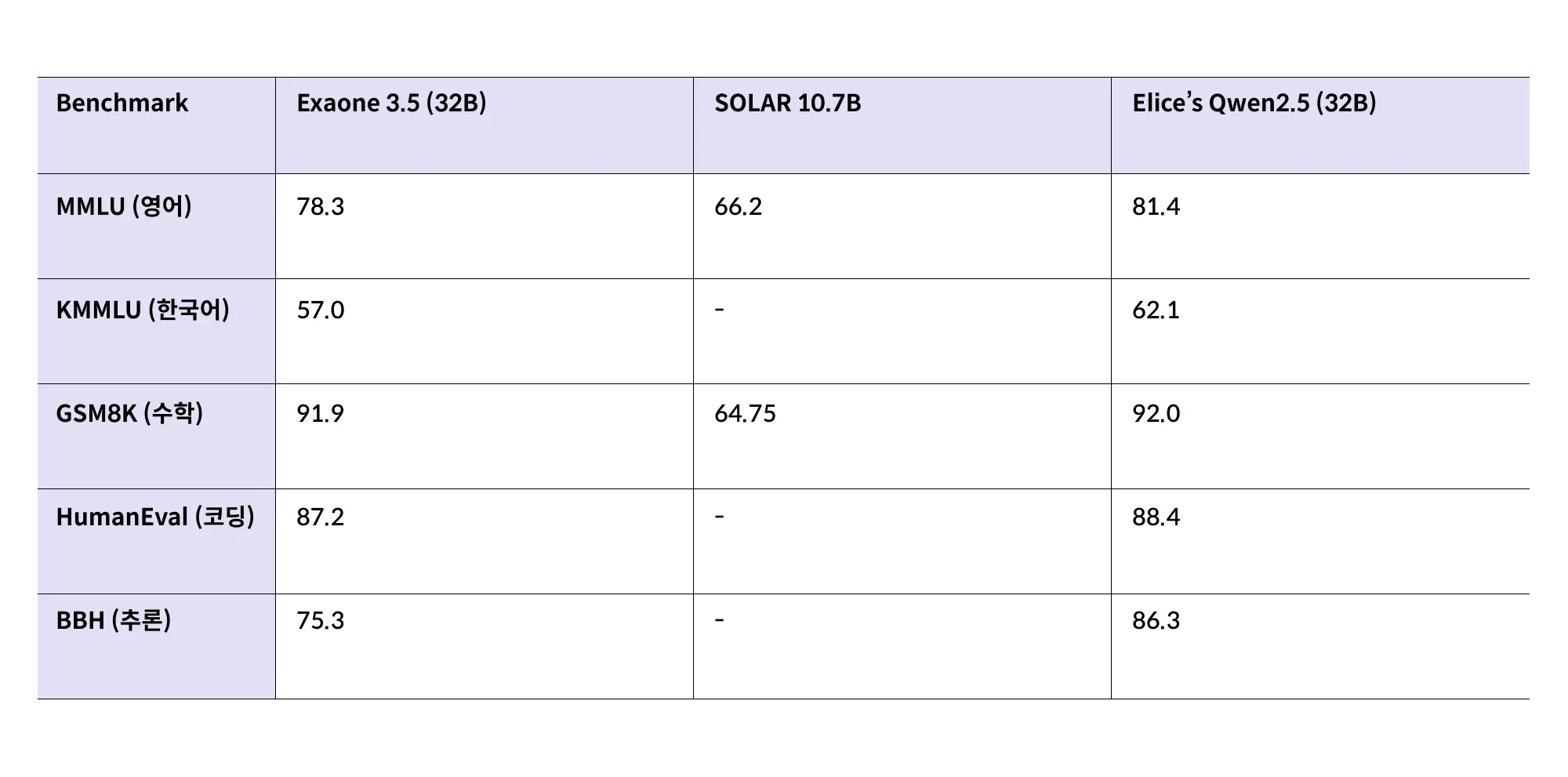

다른 한국어 특화 모델들과 비교해보면?

유사한 서비스인 Exaone, SOLAR와 비교해보았을때도 엘리스의 Qwen2.5 모델은 단순한 “한국어 특화”를 넘어, 다목적 AI 성능에서도 두각을 나타냅니다.

Exaone, SOLAR도 우수한 서비스이나 엘리스 Qwen2.5는 영어와 한국어 모두에서 높은 일관성과 성능을 보여주고 있다는 것을 알 수 있습니다.

실제 서비스에는 어떻게 활용되고 있을까?

이미 엘리스는 해당 모델을 일부 제품 및 서비스에 직접 사용하고 있습니다.

- 툴콜링 가능한 AI 에이전트

- 교육용 고급 RAG 기반 애플리케이션

- 내부 마이크로서비스

실제 운영 환경에서의 안정성을 증명하고 있다는 점에서 해당 모델의 실무 적용 가능성을 훨씬 높게 평가할 수 있습니다.

실무 적용을 고려하는 개발자에게 중요한 포인트

- 32B 모델은 단일 GPU에서도 실행 가능

- 4/8-bit 양자화 버전 제공 → 경량화 배포

- Apache 2.0 오픈소스 라이선스 → 커스터마이징, 파인튜닝, 서비스 적용 모두 자유롭게 가능

마무리: 실험은 끝났고, 이제 실전이다

지금까지 엘리스 Korean Qwen2.5 모델의 구조, 성능, 실제 적용 사례를 살펴봤습니다.

- 한국어에 특화된 오픈소스 LLM

- 최신 정렬 기법을 적용한 고정밀 튜닝

- 실제 서비스를 통해 검증된 성능

이런 결과는 ‘한국어 AI는 영어 모델의 하위 옵션’이라는 인식을 넘어 한국어에 맞는 모델을 선택하는 시대가 되었다는 것을 보여주는 사례라고 생각합니다.

엘리스 Korean Qwen2.5 모델(32B / 72B)은 개발자 누구나 엘리스클라우드 모델 라이브러리를 통해 직접 프롬프트를 입력해보고 결과를 확인할 수 있는 환경이 준비되어 있습니다.

“한국어 LLM을 직접 만져보고 싶은데 어디서부터 시작하지?”

라는 고민이 있었다면, 지금이 가장 적절한 타이밍일지도 모릅니다.

이 외에도 엘리스클라우드 모델 라이브러리에는 다양한 모델들이 준비되어 있으니, 관심 있는 분들은 무료로 사용해보셔도 좋을 것 같습니다.

- #오픈소스 모델 라이브러리

- #Qwen2.5